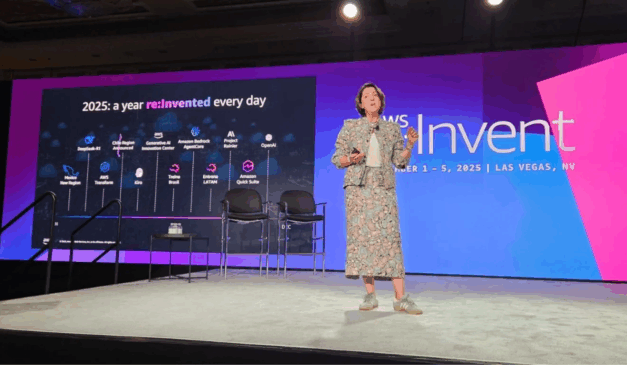

A Amazon chegou tarde na corrida da inteligência artificial, mas tenta acelerar o passo. No re:Invent 2025, a AWS fez 25 anúncios para mostrar que ainda pode ser protagonista dos agentes autônomos aos chips, passando por infraestrutura e novos modelos.

A palavra de ordem é “agente”. Para Matt Garman, CEO da AWS, o futuro das empresas será composto por bilhões deles, programáveis, autônomos e integrados ao fluxo de trabalho. A AWS quer ser a base dessa revolução, segundo o “Startups”.

Agentes, modelos e chips: o combo da AWS

Para sustentar essa visão, a AWS dobrou o número de LLMs disponíveis no Bedrock, adicionou modelos da Mistral AI e lançou a família Nova 2, com destaque para o Nova 2 Omni, que combina múltiplos modelos para entregar respostas mais refinadas.

Mas o coração da ofensiva está nos chips. A nova geração Trainium3 já está no mercado, com promessa de 4,4x mais performance e 4x mais eficiência energética. E o Trainium4, em desenvolvimento, vem com suporte ao NVLink Fusion, mirando workloads pesados de IA.

O desafio: sair da sombra do Google e da Nvidia

Enquanto o Google acelera com o Gemini 3 e domina o fornecimento de chips via Alphabet, e a Nvidia mantém hegemonia em data centers, a AWS corre por fora. Ainda não tem um modelo de IA que rivalize com o GPT-5 ou Gemini 3 Pro, e precisa convencer o mercado a migrar de chips Nvidia para Trainium.

A aposta é na experiência dos desenvolvedores: menos tempo gerenciando infraestrutura, mais tempo criando. Segundo Garman, a missão da AWS é “reinventar a forma como todos nós trabalhamos”.